Imagina una manifestación en Pyongyang, Corea del Norte. Miles de personas ondean banderas y aplauden mientras los soldados inspeccionan a la multitud en busca de signos de descontento y de personas que sea evidente que finjan su amor por el régimen. Ahora imagina que esos soldados tienen cámaras que pueden evaluar las expresiones faciales, lo que les informa con certeza de quién está teniendo una reacción no genuina.

Este escenario no es improbable. Aunque la tecnología de detección de emociones no está muy extendida, está lejos de ser una ficción. Las empresas privadas y los gobiernos ya la utilizan. Las democracias y los activistas de derechos humanos deben estar preparados para las implicaciones de esta tecnología y trabajar para crear un consenso internacional contra su uso antes de que se generalice.

La próxima etapa de la tecnología invasiva

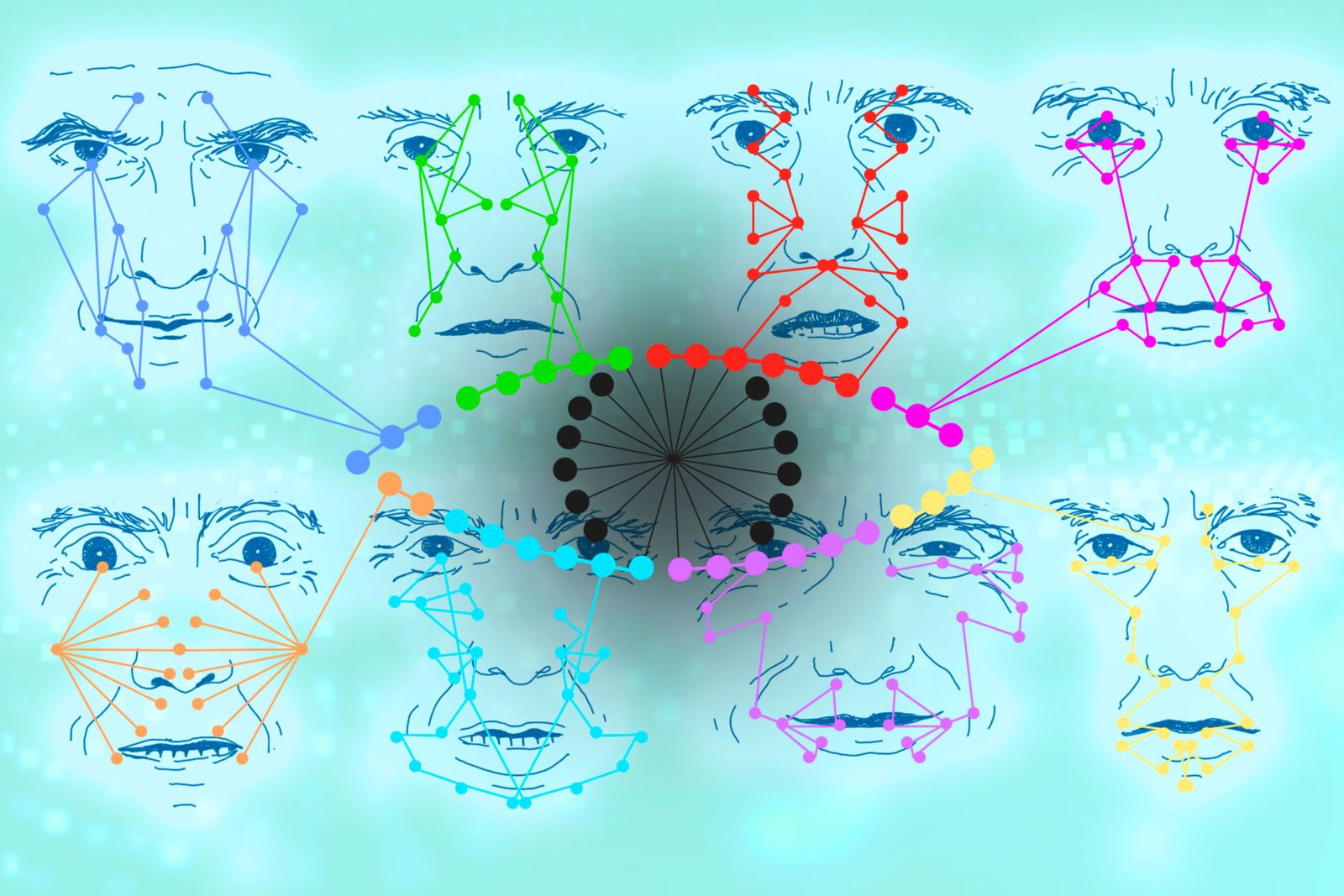

Mientras que la tecnología de reconocimiento facial ya plantea retos para la protección de los derechos humanos, el software de reconocimiento de emociones es un paso más hacia el territorio distópico. Entra en la categoría de la computación afectiva, que utiliza datos, algoritmos e inteligencia artificial para reconocer e influir en las emociones humanas. Como muchas formas de tecnología, su potencial para el beneficio de la sociedad se puede manipular con facilidad para la explotación y la represión.

Algo muy parecido a la hipótesis de Pyongyang ya está ocurriendo en China. Según un informe de la BBC, los uigures de la región autónoma de Xinjiang son sometidos a pruebas con este software. Si bien el proceso de pruebas no consensuadas por sí solo es una violación atroz de los derechos de las personas, el contexto sociopolítico de Xinjiang deja entrever las siniestras formas en que esta tecnología podría ser utilizada por los regímenes autoritarios.

Uno de los principales motivos de la represión del gobierno chino en Xinjiang es el deseo de Pekín de reprimir cualquier creencia separatista entre los habitantes de la región uigur. Los programas informáticos de detección de emociones se basan en la premisa, en gran medida discutida, de que las personas muestran un conjunto universal de emociones: que hay signos fiables y coherentes de auténtica felicidad, por ejemplo. Los actores autoritarios podrían, en teoría, intentar utilizar el software de detección de emociones para identificar el falso entusiasmo de alguien que recita mantras patrióticos o detectar una denuncia poco sincera del sentimiento separatista. Sería un golpe de gracia para quienes buscan controlar por completo a sus poblaciones en cuerpo y mente, si funcionara.

En su estado actual, la tecnología es muy defectuosa, lo cual presenta otros peligros. Por ejemplo, en ámbitos como la aplicación de la ley, una lectura imperfecta de las emociones de un acusado podría llevar a conclusiones inexactas y a condenas potencialmente falsas. Algunos expertos han pedido la prohibición total de esta forma de tecnología en Estados Unidos por este motivo, y argumentan que esta tecnología amenaza las libertades civiles al suponer que los movimientos faciales y el tono de voz podrían utilizarse como pruebas de criminalidad. La profesora Kate Crawford ha establecido un paralelismo entre el software de detección de emociones y los polígrafos, o “detectores de mentiras”, ya que ambos son formas de tecnología profundamente problemáticas y poco fiables que pueden causar graves daños cuando las autoridades hacen un mal uso de ellas.

Dado que la idea de utilizar la tecnología de reconocimiento de emociones como herramienta de gobierno proviene de una premisa completamente errónea, la prohibición tiene sentido. En una reciente entrevista que mantuve con Vidushi Marda y Shazeda Ahmed, autoras de un informe de Article 19 sobre el tema, la detección de emociones es “tan invasiva y problemática que una prohibición total de la experimentación, prueba y construcción de estas tecnologías es el único camino a seguir”. Además, afirman que la premisa fundamental de la tecnología —que hay un “conjunto de emociones que la gente debería sentir”— es tan errónea y peligrosa que nadie debería utilizarla para informar sobre decisiones de gobierno, negocios o cualquier otra cosa.

Una breve ventana para actuar

Aunque es un buen comienzo, las prohibiciones de las democracias individuales no impedirán que los gobiernos autoritarios utilicen, adapten y vendan la tecnología de detección de emociones a otros países. Ya sea al utilizar la IA de reconocimiento facial para hacer un perfil de las minorías étnicas o rastrear los movimientos de la gente a través de una aplicación telefónica obligatoria, los gobiernos han demostrado una y otra vez que utilizarán la tecnología hasta su potencial máximo y más despiadado.

El creciente uso de esta tecnología reforzará la capacidad de los actores autoritarios para ejercer la represión transnacional, socavar las democracias y “remodelar las normas e instituciones internacionales para servir a sus propios intereses”. Cuanto más tiempo tenga la tecnología de reconocimiento de emociones para introducirse en áreas clave de la gobernanza, como la seguridad nacional y la policía, más difícil será hacer que la opinión pública se oponga a ella.

Las democracias tienen la urgente responsabilidad de actuar. Naciones Digitales (ND), un foro de países con economías digitales y tecnológicas líderes, creado con el objetivo de promover el uso responsable de la tecnología entre los gobiernos, está bien situada para liderar la lucha en este asunto. Aunque su número de miembros es reducido, los Estados miembros de ND son verdaderamente globales, e incluyen miembros en Europa, Asia, Latinoamérica y Oceanía; esta diversidad ayudaría a ND a construir un consenso global para una moratoria mundial sobre el software de detección de emociones para evitar su proliferación.

Como agrupación multilateral más pequeña y ágil, ND también puede estar más aislada de las críticas de burocracia y estancamiento a las que se enfrentan agrupaciones más grandes como las Naciones Unidas. Marda y Ahmed destacan que “la mayor parte de las prohibiciones tecnológicas históricas proceden de acuerdos internacionales por los que se prohíbe el uso de determinadas tecnologías”. Un comunicado en el que se declare la intención de los Estados miembros de ND de prohibir esta tecnología y en el que se pida a los demás que apliquen sus propias prohibiciones sería un buen comienzo para hacer que la opinión pública mundial se oponga al software de detección de emociones. Un comunicado de este tipo también debería poner de relieve y demostrar la absoluta ineficacia de la detección de emociones como inversión, apelando al pragmatismo y a la ética.

Ahora es también un momento clave para que los activistas hagan campaña contra el despliegue y la implementación del software de detección de emociones. Al tratarse de un área tecnológica que pasa relativamente desapercibida para muchos hacedores de política, existe la posibilidad de que se convierta en un caballo de Troya que cause graves daños antes de que se note. Las organizaciones de derechos humanos deberían dirigir sus esfuerzos de defensa hacia la concienciación de los responsables políticos sobre los peligros de esta tecnología. Los esfuerzos de la campaña deben centrarse en la concienciación del público, ejerciendo una mayor presión sobre los políticos y los gobiernos para que tomen medidas estrictas sobre el software de detección de emociones antes de que su uso gane aceptación.

Crear un consenso contra una tecnología desconocida como la detección de emociones llevará tiempo y no tendrá éxito en todos los frentes. Sin embargo, si las democracias adoptan un enfoque unificado, acabarán asegurando una cascada de normas que impidan que esta tecnología se imponga y diezme la privacidad, la libertad de expresión y otros innumerables derechos humanos. Sólo este enfoque proactivo y preventivo ayudará a controlar esta tecnología antes de que los peligrosos intentos de leer los pensamientos y sentimientos de los ciudadanos se conviertan en una práctica habitual en los gobiernos de todo el mundo.